La dualité événement-donnée en architecture agentique

Entre mouvement et trace, une nouvelle façon de penser l’intelligence des systèmes.

Sommaire

J’ai toujours été fasciné par la dualité onde–particule découverte en physique quantique. N’est-il pas incroyable qu’une même réalité puisse être à la fois énergie en mouvement et matière observable ?

Cet intérêt est né sur les bancs de mon ancienne école d’ingénieurs et du numérique, l’EFREI. Et il m’accompagne depuis mes premiers développements temps réel jusqu’à mes réflexions actuelles sur les architectures data et agentiques.

Cet été 2025, face à la mer, j’ai éprouvé à nouveau ce sentiment.

La lumière y dessinait des reflets changeants, oscillant entre transparence et éclat.

Il m’est alors apparu que tout dépend de la rencontre entre ce qui éclaire et ce qui reçoit.

Cette observation m’a évoqué la dualité onde–corpuscule et le caractère de son observation. Selon le regard qu’on lui porte, la lumière se révèle en effet tour à tour onde ou particule.

Ce jour-là, j’ai voulu revisiter ces fondements. J’ai pris le parti de relire des articles et d’écouter un livre audio sur la mécanique quantique. Je souhaitais valider une conviction intime fondée sur une analogie.

La structure profonde de nos systèmes d’information obéit, elle aussi, à une dualité naturelle entre mouvement et mémoire.

Ce parallèle me semble patent dans les systèmes d’information modernes. On peut imaginer que l’événement représente l’onde, c’est-à-dire le mouvement, le flux, le signal. Et que la donnée coïncide avec la particule, la trace, la mémoire, la forme.

Comprendre cette dualité, c’est comprendre comment bâtir des systèmes plus réactifs. C’est comprendre comment les rendre adaptatifs et intelligents. C’est aussi être capable de relier le monde physique et le monde digital dans un flux continu d’interactions.

Du capteur à la donnée : quand l’onde devient matière

Dans les systèmes embarqués temps réel, un simple capteur peut déclencher toute une chaîne d’actions.

« Point de chaleur détecté, tuyère avion de chasse aux coordonnées x : y : z. »

Ainsi, un capteur infrarouge perçoit une variation, le code l’interprète. L’événement devient ensuite une donnée.

L’événement (l’onde) se condense, de la sorte, en information stable. Celle-ci guide le système dans son action et éclaire les décisions du pilote.

Flux éditoriaux : de la dépêche au signal

Plus tard, dans les systèmes d’information journalistiques, la logique demeurait la même. Une dépêche AFP, composée de texte brut et analysée selon certains critères (analyse codée, sans IA à l’époque), déclenchait un événement éditorial. Celui-ci avait pour but d’alerter un journaliste sur un sujet potentiel pour l’édition du lendemain matin.

Intégration des applications et Business Intelligence : la donnée comme déclencheur

J’ai observé cette même dynamique dans la spécialité de l’intégration des applications et de la Business Intelligence, domaine dans lequel les données conditionnent les décisions stratégiques des entreprises.

Une donnée transformée et publiée sur un bus applicatif activait un événement déclencheur pour d’autres systèmes, une mise à jour de la donnée dans différentes applications métiers. C’était un véritable signal de vie dans un écosystème que je devais interconnecter.

Le flux comme mémoire vivante

Dans tous ces cas, l’événement devient donnée. Le flux se fige en mémoire. Transformant le mouvement en trace exploitable. C’est le moment où le possible devient réel.

C’est l’équivalent numérique du passage d’un état de possibilité à un état réel. Autrement dit, l’instant précis où le flux se transforme en donnée, où l’intention devient trace.

Pour clarifier mon propos, imaginez un consommateur naviguant sur un site e-commerce. Ses hésitations représentent un flux d’intentions. À l’instant précis où il valide son panier, ce comportement fluide se fige en données structurées. Il transforme ainsi une simple possibilité d’achat en transaction mesurable que l’entreprise peut analyser.

La mécanique quantique de l’information

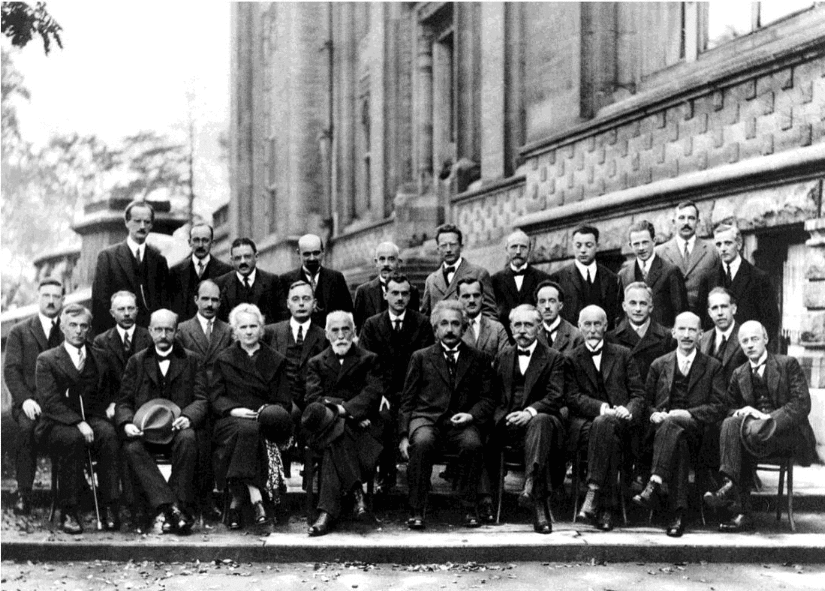

Pour préciser l’origine de cette idée, lors du Congrès Solvay 1, en 1927, Bohr et Heisenberg ont proposé une idée vertigineuse : la réalité ne se révèle qu’au moment où on la regarde 2.

Préalablement, Werner Heisenberg 3 énonça le principe d’incertitude qui conduira à un échange cocasse avec Albert Einstein 4.

En langage profane ce principe se résume de la façon suivante : Heisenberg signifie que la réalité n’existe pas vraiment avant d’être observée, la particule n’est qu’un ensemble de possibilités !

Pour rendre les choses plus tangibles à l’esprit, imaginez une pièce de monnaie qui tourne sur elle-même. Tant qu’elle tourne, visuellement, elle n’est ni pile ni face. Elle est un peu les deux à la fois. C’est seulement quand on l’attrape (quand on l’observe) qu’elle devient soit pile, soit face. Selon Heisenberg, les particules microscopiques se comportent un peu comme ça. Avant qu’on les regarde, elles existent dans plusieurs états en même temps.

Einstein, lui, s’y oppose. Il refuse l’idée que le réel dépende du regard humain en lâchant cette phrase : « Je veux croire que la lune est bien là, même quand je ne la regarde pas 5. »

Participants au 5e Congrès Solvay tenu en octobre 1927 sur le thème « Électrons et photons » à l’Institut international de physique Solvay dans le parc Léopold à Bruxelles. (Dix-sept des vingt-neuf personnalités présentes sont lauréates d’un prix Nobel.) 6.

Finalement, avant l’observation, le monde n’est qu’un champ de possibles : un ensemble de potentialités en attente d’interaction.

Ce basculement du possible à l’actuel, que la physique appelle « réduction du paquet d’onde 7 ». Ce dernier constitue le moment où une multitude de possibles se condense en un seul état observé. Il trouve aujourd’hui un écho inattendu dans nos architectures.

Observation et événement : le point de bascule

Dans le propos de cet article, indubitablement Einstein a raison, le système d’information existe bien (serveurs, réseaux et d’infrastructures bien concrets).

Mais, à la manière du principe d’incertitude de Heisenberg, chaque événement qui le traverse agit comme une observation. Il fige un instant du flux, lui donne forme et sens.

Transposons cela au système numérique. Chaque fois qu’un utilisateur clique sur un site web, qu’une transaction bancaire est effectuée ou qu’un capteur connecté prend une mesure, une transformation s’opère. Ces « observations » du système convertissent ce qui n’était qu’un simple signal en une donnée concrète et mesurable.

Avant cette capture, l’information n’existe qu’à l’état de signal parmi d’autres. L’acte d’observer, qu’il s’agisse d’un algorithme de détection, d’une API de streaming ou d’un moteur d’analyse, crée la donnée autant qu’il la révèle.

Maintenant, imaginons un instant un site web avant qu’un utilisateur ne clique. Plusieurs chemins sont possibles. Mais dès que le clic survient, une seule de ces possibilités se matérialise et devient une donnée réelle, enregistrée dans le système. Cette mécanique rappelle étrangement les principes de la physique quantique. L’acte d’observation, qu’il soit numérique ou physique, transforme l’onde des possibles en une particule de réalité.

Dans l’écosystème numérique, c’est donc l’observation (le clic, la mesure) qui donne vie aux données. Ainsi, sans observer les évènements on ne peut détecter une nouvelle donnée pertinente.

Streaming : la circulation du possible

Étienne Klein 8 parle de réel « suspendu », d’un « monde de potentialités » 9, et Niels Bohr 10 de « phénomènes qui n’existent qu’à travers l’acte de mesure 11 » éclairent d’un jour nouveau notre compréhension du streaming.

Le streaming est ce mouvement continu qui véhicule le champ des possibles, sans les fixer.

Quand le possible devient mémoire

Parlons à présent du bus streaming, cette infrastructure logicielle qui transporte en continu des informations.

Dans nos architectures modernes, il incarne le champ des possibles. Comprenez un espace où circulent des événements en attente d’interprétation. Et ce, jusqu’à ce qu’un calcul ou une observation les transforme en données persistées.

En physique quantique, Werner Heisenberg 12 puis Niels Bohr 13 ont montré qu’une particule n’a ni position ni état définis avant d’être observée. Elle n’existe qu’à travers l’acte de mesure.

De même, dans un système d’information, l’événement ne devient réel qu’au moment où il est saisi — lorsque le flux, observé, prend forme dans la mémoire des données.

Vers une physique du système d’information

Ainsi, nos systèmes d’information orchestrent ce passage permanent entre flux et persistance, perception et souvenir comme si chaque système d’information rejouait à sa manière le théâtre quantique du réel.

La matière en mouvement : quand la donnée redevient événement

Mais l’inverse est tout aussi vrai. Dans une architecture moderne, la donnée peut redevenir événement.

Dès que celle-ci alimente un modèle d’IA, un moteur de règles métier ou une action automatisée, elle reprend vie.

Ainsi, une donnée client peut déclencher une recommandation personnalisée.

Flux actif : de la donnée au signal

Puisons un exemple dans le registre des systèmes d’information distribués et du traitement de données en temps réel (« streaming de données » ou « data streaming 14 »).

Lorsqu’une donnée est diffusée en flux via la plateforme Kafka 15, elle quitte son stockage statique. La plateforme transmet les informations en temps réel entre différents systèmes, et la donnée redevient alors un signal actif, capable de déclencher d’autres actions.

La donnée statique se remet en mouvement, tout comme la matière qui redevient onde. C’est le cycle naturel des architectures intelligentes : une circulation permanente entre état et action, entre mémoire et flux.

L’intelligence comme boucle vivante

La donnée statique se remet en mouvement, tout comme la matière redevient onde.

C’est le cycle naturel des architectures intelligentes : une circulation permanente entre état et action, entre mémoire et flux.

L’apparition des triggers dans les bases de données en est un exemple patent : ils incarnent cette capacité du système à réagir en temps réel à un événement, transformant une simple modification en action consciente du système d’information.

La donnée n’est plus un simple résultat ; elle devient acteur, déclenchant de nouvelles dynamiques au sein du système.

Norbert Wiener 16, avec la cybernétique, montrait que l’intelligence émerge de la boucle d’information : percevoir, agir, corriger.

Cette vision trouve aujourd’hui un écho dans nos architectures numériques : elles relient la circulation des flux à la mémoire des données, le mouvement du monde à sa trace.

Et c’est sans doute là que réside la dualité événement-donnée : ce dialogue permanent entre le flux qui transporte la vie et la donnée qui en garde la mémoire.

L’intelligence des flux au service des trois voies de la performance Les architectures événementielles incarnent ainsi la boucle vivante entre perception et mémoire.

En réconciliant le flux et la trace, elles offrent à l’entreprise la capacité de se différencier sur un axe de valeur majeur. Elles contribuent aussi à en consolider un second, dans la logique du modèle développé par les chercheurs américains Michael Treacy et Fred Wiersema 17.

Ce modèle, établi en 1993, identifiait trois grandes stratégies de création de valeur. La première, l’excellence opérationnelle (produire efficacement et à moindre coût). La seconde, l’intimité client (comprendre et servir chaque client au plus près de ses besoins). La troisième enfin la supériorité produit (innover pour proposer la meilleure offre du marché).

Des architectures orientées flux à l’IA agentique

De la dualité stream–table aux systèmes agentiques autonomes, chaque étape illustre comment les données et les événements se répondent. Ils donnent vie à des architectures véritablement intelligentes.

Le modèle « stream–table » : penser la donnée dans la continuité

Ma réflexion s’inscrit dans la continuité des travaux de Jay Kreps, Martin Kleppmann et Lutz Hühnken. Ces derniers ont chacun exploré la transformation des architectures logicielles autour du paradigme « stream–table ». Ce dernier désigne la complémentarité entre le flux d’événements continus (stream) et l’état agrégé qu’ils produisent (table), deux visions indissociables d’une même donnée.

Ainsi, Jay Kreps a montré comment le log distribué devient l’élément unificateur entre traitement en flux et stockage persistant. Cette approche conduit à repenser la cohérence des données à grande échelle 18.

Martin Kleppmann, lui, a proposé de concevoir les bases de données comme des flux d’événements, inversant ainsi la logique traditionnelle du stockage 19.

Lutz Hühnken, enfin a approfondit l’idée de Martin Kleppmann en distinguant la double nature des événements, à la fois faits historiques et états dérivés, qui fonde la logique des architectures pilotées par les événements 20.

Ma proposition étend cette logique au plan systémique : celle d’une dualité événement–donnée où le mouvement et la mémoire, le monde et sa trace, s’interpénètrent pour donner naissance à des architectures véritablement intelligentes.

Quand l’observation devient action

La dualité stream–table nous enseigne que toute donnée naît d’un mouvement, et que tout mouvement finit par laisser une trace.

Derrière cette relation technique se cache une tension plus profonde celle de la dualité événement–donnée.

Mais que se passe-t-il lorsque cette trace, à son tour, commence à observer le mouvement qui l’a engendrée ?

Alors, la donnée cesse d’être mémoire : elle devient regard.

Observer un événement, c’est déjà en produire un nouveau car toute observation transforme ce qu’elle observe selon le principe d’incertitude de Heisenberg : la réalité observée dépend de l’observation.

Le système d’information, autrefois simple réceptacle, entre ainsi dans une boucle vivante où percevoir, comprendre et agir ne font plus qu’un.

Dans ce cycle, la connaissance ne s’accumule pas : elle se régénère.

Et c’est de cette résonance entre le flux et sa conscience que surgit l’IA agentique, une intelligence où la donnée se souvient du monde autant qu’elle le réinvente.

De la dualité événement–donnée à l’intelligence agentique

De la dualité événement–donnée ou, dans le langage des architectes, stream–table jusqu’à l’émergence de systèmes autonomes, chaque étape illustre la même dynamique : celle d’un monde où le flux et la mémoire se répondent.

Le stream incarne le mouvement de l’évènement, la perception en temps réel tandis que la table représente la mémoire stable, la connaissance accumulée, les données.

L’événement donne la vie, la donnée donne la mémoire. Ensemble, ils forment le système nerveux de l’IA agentique.

Les agents, ces entités logicielles, parfois minuscules, perçoivent le monde à travers les événements qui circulent dans le système et s’alimentent de l’information stockée déjà observée.

Chaque agent agit dans un périmètre restreint, mais avec une autonomie réelle : il écoute, interprète, puis décide ou conseille.

Certains agents sont réactifs, ils réagissent instantanément à un signal précis, comme un réflexe numérique.

D’autres sont contextuels, ils tiennent compte de la mémoire des données, du temps ou de la situation avant d’agir.

Et quelques-uns, plus évolués, deviennent cognitifs : ils planifient, coordonnent d’autres agents, évaluent les effets de leurs décisions et révisent leur stratégie.

Ensemble, ils forment un système nerveux numérique, où chaque événement perçu peut déclencher une action, et chaque action laisser une trace.

C’est de ce dialogue que surgit l’IA agentique : des systèmes capables d’observer et d’interpréter les flux, d’agir sur eux, d’apprendre de leurs traces et d’en générer de nouvelles. Une boucle continue où percevoir, raisonner, agir et apprendre se confondent pour donner vie aux architectures agentiques.

Quand l’intelligence émerge de la relation

Ainsi, l’intelligence ne réside plus dans un modèle central, mais dans la dynamique des interactions : une intelligence distribuée, contextuelle et vivante, née du dialogue permanent entre le flux et la mémoire.

Les architectures agentiques sont la mise en œuvre opérationnelle de la dualité événement–donnée. Celui des événements, fluide et mouvant, animé par les flux que transportent un bus évènementiel comme Kafka.

Et celui des données, stable et structuré, gardé par les lakehouses 21, les warehouses 22, les 23 catalogues.

Entre les deux, les agents se tiennent comme des médiateurs : ils écoutent et réagissent, donnant à ces systèmes la capacité de percevoir, comprendre et agir.

Là où l’intelligence artificielle traditionnelle observe, apprend, puis prédit à partir d’un monde figé de données, des traces du passé, soigneusement stockées et analysées pour construire des modèles.

C’est dans ce va-et-vient que naît une nouvelle forme d’intelligence : une intelligence située, contextuelle, autonome, capable de s’adapter aux signaux du monde en temps réel.

Une vision pour les architectes de demain

En fin de compte, dans nos architectures, la donnée est la mémoire du monde. L’événement en est la vibration vitale. Les deux forment le système nerveux de l’intelligence du système d’information moderne. L’intelligence des systèmes ne se situe plus dans le modèle, mais dans le flux qui le relie au monde.

La dualité événement–donnée nous rappelle que la valeur d’une donnée ne réside pas seulement dans ce qu’elle décrit, mais dans ce qu’elle permet d’accomplir.

Dans un monde en mouvement, nos systèmes doivent apprendre à percevoir, interpréter et réagir en temps réel.

L’enjeu n’est plus seulement de maîtriser les flux, mais d’en faire le socle d’une intelligence capable d’agir.

C’est tout le sens de l’ère agentique : faire dialoguer la mémoire des données et le mouvement des événements pour bâtir des systèmes véritablement vivants.

La physique quantique et les architectures data partagent des principes fondamentaux qui méritent d’être explorés. C’est-à-dire un monde où les systèmes ne se contentent plus de calculer, mais comprennent et interagissent avec leur environnement.

J’invite, à ce propos, les architectes, ingénieurs et curieux du numérique à réfléchir à cette question :

Comment vos systèmes transforment-ils les événements du monde en données, et vos données en nouveaux événements ? Et si cette boucle devenait le socle même de votre architecture Agentic AI ?

Remerciements et note personnelle

Cette réflexion est née de mon parcours à l’EFREI, nourrie par mes années chez Nexworld, ancien cabinet de conseil, maintenant intégré à Onepoint. Elle s’y prolonge à présent, auprès de passionnés qui explorent sans relâche les architectures data et agentiques.

Je tiens à remercier celui qui m’a inspiré : Jean Klein (membre de l’Institut des Nanosciences de Paris et professeur de physique à l’EFREI, disparu en 2023). Il m’a fait découvrir la physique quantique et les travaux de Planck, Einstein, Bohr, Heisenberg, Schrödinger et Dirac.

Un clin d’œil amical à Serge Bouvet pour sa plume exigeante et le soin apporté à tracer l’information juste.

Et surtout, merci à ma femme. Grande lectrice et gardienne du temple de notre bibliothèque, elle a consacré son temps à m’aider à rattraper les cours de français, de littérature et de philosophie. Je les avais joyeusement séchés pour mieux participer aux cours de maths et de physique.

Elle m’a épaulé et relayé dans la vie familiale avec nos jeunes enfants. Et ce, durant toutes ces années où je rentrais trop tard de chez mes clients.

J’avais la tête pleine de données et les yeux pleins de nouvelles façons de les faire voyager. Grâce à elle, j’ai pu trouver le temps de réfléchir aux fondamentaux et aux constats. Ils m’ont conduit à partager ici ma conviction. Comme quoi, on peut manquer de lettres, mais pas d’émerveillement devant la beauté des équations ni devant tout ce qu’elles rendent possible dans le monde digital qui nous entoure.

C’est au sein des équipes Onepoint, animées par la même passion pour les plateformes de données, les architectures événementielles, l’intelligence artificielle et l’Agentic AI, que je poursuis aujourd’hui mon chemin.

Références

1. Don Howard, « Revisiting the Einstein-Bohr Dialogue », 3.nd.edu, page 19, 41 pages, 2007.↩︎

2. Bohr, 1935, Physical Review↩︎

3. Werner Heisenberg (1901-1976), physicien allemand, a énoncé en 1927 le principe d’incertitude, pierre angulaire de la mécanique quantique.↩︎

4. Don Howard, « Revisiting the Einstein-Bohr Dialogue », 3.nd.edu, page 1, 41 pages, 2007.↩︎

5. D. Song, « Einstein’s Moon », ufn.ru, Uspekhi Fizicheskikh Nauk, Russian Academy of Sciences, page 1, 2 pages, 2012.↩︎

6. Photographie Creative Common Wikipedia, Photograph by Benjamin Couprie, Institut International de Physique Solvay, Brussels, Belgium. ↩︎

7. Réduction du paquet d’onde ou « Wave function collapse », « General Relativity and Gravitation », On Gravity’s role in Quantum State Reduction, springer.com, Volume 28, pages 581–600, May 1996.↩︎

8. Physicien et philosophe des sciences, Étienne Klein (CEA) explore la façon dont la physique interroge notre rapport au réel notamment à travers la mécanique quantique, le temps et le langage scientifique.↩︎

9. Le Monde selon Étienne Klein (France Culture, 2012–2014)↩︎

10. Niels Bohr (1885-1962), physicien danois et pionnier de la pensée quantique, voyait dans l’acte d’observation non pas une simple mesure, mais un moment où la réalité se manifeste : une rencontre entre le monde et le regard.↩︎

11. Physical Review, vol. 48, 1935 ↩︎

12. « The Uncertainty Principle », stanford.edu, 2.2 Heisenberg’s argument, Stanford Encyclopedia of Philosophy, Oct 8, 2001.↩︎

13. Ibid, 5. Alternative measures of uncertainty.↩︎

14. « Kafka, pierre angulaire des Architectures Fast Data ? », groupeonepoint.com, 2019.↩︎

15. Stéphane Chaillon, Frederick Miszewski, Laurent Rossaert, « Stream processing : comprendre les nouveaux enjeux des données diffusées en continu», groupeonepoint.com, 2019.↩︎

16. mathématicien américain, est le fondateur de la cybernétique — la science du contrôle et de la communication dans les systèmes. Il fut l’un des premiers à rapprocher le fonctionnement du vivant et celui des machines, en montrant que l’échange d’information est au cœur de toute organisation stable.↩︎

17. Michael Treacy and Fred Wiersema, « Customer Intimacy and Other Value Disciplines », hbr.org, 1993.↩︎

18. Jay Kreps, « The Log: What Every Software Engineer Should Know About Real-Time Data », engineering.linkedin.com, 2013↩︎

19. Martin Kleppmann, « Turning the Database Inside Out », martin.kleppmann.com, 2015.↩︎

20. Lutz Hühnken, « The Dual Nature of Events in Event-Driven Architecture », martin.kleppmann.com, 04 Mar 2015.↩︎

21. Lakehouses : plateforme où se rassemblent toutes les données d’une organisation, qu’elles soient brutes ou structurées. C’est une sorte de lac de mémoire où les traces du flux viennent se déposer avant d’être analysées.↩︎

22. Warehouse (entrepôt de données) : espace plus ordonné et plus rigide, où les données sont classées, vérifiées et prêtes à être utilisées pour guider les décisions (la mémoire organisée de l’entreprise).↩︎

23. Catalogue de données : répertoire qui permet de savoir quelles données existent, où elles se trouvent et à quoi elles servent. C’est la boussole qui relie le flux vivant des événements à la mémoire stable des informations.↩︎