La course à l’IA est-elle soutenable ?

En ce début d’année 2025, les nouvelles annonces concernant les dernières avancées de l’IA sont omniprésentes dans le paysage de la Tech. L’IA est une véritable lame de fond qui va bouleverser nos futurs usages du quotidien. Cette course à l’IA s’effectue cependant au prix d’un impact toujours plus fort sur notre environnement et nécessite des investissements qui semblent de plus en plus démesurés. Dans ce contexte, on peut s’interroger sur la suite. Vers où allons nous ? Vers des modèles toujours plus gros et plus puissants ou bien va-t-on s’orienter vers des investissements et des développements plus spécialisés, optimisés et plus respectueux de notre environnement ?

IA Générative : la course folle vers l’AGI !

Après les progrès majeurs constatés en 2024 avec notamment la sortie des dernières versions des modèles LLM d’OpenAI, d’Anthropic, de Google, de Meta et de Mistral, 2025 semble également plein de promesses et de fantasmes sur l’arrivée de la très attendue AGI ! L’AGI ou IA Générale désigne des systèmes d’IA capables d’égaler ou de surpasser les capacités humaines dans des tâches cognitives variées. Contrairement à l’IA actuelle, qui excelle dans des tâches spécifiques, l’AGI sera capable d’apprendre et de résoudre des problèmes dans des domaines divers sans intervention humaine. Ses capacités généralistes lui permettront d’adresser quasiment tous les domaines tels que la science, les arts, la recherche, l’automatisation et l’optimisation des processus, l’exécution de tâches complexes … Ainsi pour toujours plus de performance, cette course nécessite, à chaque nouvelle version, plus de capacité CPU, plus de données et donc une consommation d’énergie et des investissements toujours plus importants. Cette quête d’une IA générale, conduit à développer des modèles de plus en plus gros et de ce fait de plus en plus consommateurs en ressources. En effet, la croissance des ressources nécessaires à l’entraînement de chaque nouvelle génération de modèle est exponentielle.2024-2025 : le grand boom des investissements IA

En premier lieu, en termes financier ; les chiffres sont impressionnants. En 2024, les entreprises spécialisées dans l’IA générative ont levé à elles seules 56 milliards de dollars. Microsoft prévoit de dépenser 80 milliards de dollars en 2025 dans des centres de données pour la formation et l’inférence de l’intelligence artificielle. Chez Meta, la technologie IA générative est devenue la priorité absolue. Son PDG Marc Zuckerberg a annoncé le lancement d’un modèle d’IA avancé, Llama 4, avec plus de 100 000 GPU Nvidia H100. Ainsi, Meta prévoit de dépenser jusqu’à 40 milliards de dollars en 2024 en infrastructures, reflétant une augmentation de 42 % par rapport à 2023. Dans le cadre du projet Stargate, Donald Trump a annoncé un investissement de 500 Milliards de Dollars sur les quatre prochaines années, pour le développement aux Etats Unis des infrastructures nécessaires à l’IA. L’Europe n’est pas en reste ! Emmanuel Macron a répondu à l’annonce du projet Stargate faite par Donald Trump avec un plan d’investissement massif de 109 milliards d’euros pour développer l’IA en France. Une part importante de ces 109 Md€ proviendra des Émirats arabes unis avec un financement entre 30 et 50 Milliards d’Euros. Ce plan comprend en effet un accord stratégique avec les Émirats arabes unis pour construire le plus grand campus IA d’Europe et la construction d’un datacenter d’une puissance de 1 GW dédié à l’IA en France, soit celle d’un réacteur nucléaireUne consommation énergétique toujours plus importante

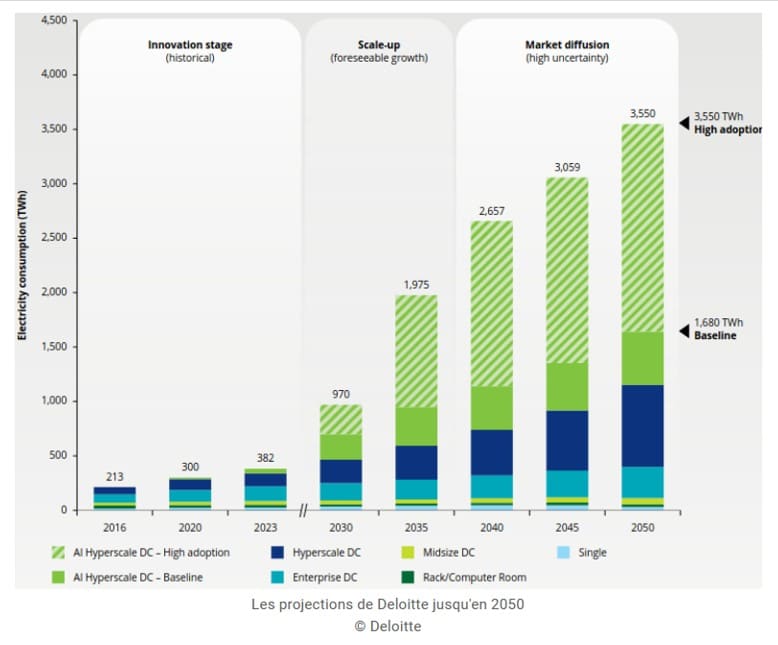

En second lieu, en termes d’énergie. Ainsi Zuckerberg a annoncé un cluster de 2GW pour 2025 et Microsoft et OpenAI ont lancé le projet Stargate pour créer plusieurs clusters de 2 à 5GW. A titre de comparaison, un cœur de centrale nucléaire produit environ 1 GW. Sam Altman, le PDG d’OpenAI, prône la course au gigantisme pour les centres de données d’IA. Il prévoit de construire 5 à 7 centres de données de 5 Gigawatts, soit l’équivalent pour chacun de la consommation de 3 millions de foyers. Les data centers nécessitent une consommation énergétique colossale. Selon une étude réalisée par le cabinet Deloitte, en suivant le rythme d’adoption actuel, la consommation électrique des centres de données, sous la pression de l’IA, pourrait être multipliée par 9 d’ici 2050.

Ainsi, le Gartner prévoit que 40% des centres données seront menacés de pénuries d’ici 2027.

Voilà qui pourrait remettre en cause les ambitions de développement de l’IA, la croissance de nos infrastructures énergétiques étant beaucoup plus lente que celle du marché de l’intelligence artificielle.

IA Générative : un besoin de toujours plus de données

Enfin, en termes de données. L’entrainement de ces modèles nécessite en effet des quantités gigantesques de données. Ainsi, pour l’entraînement de ChatGPT 4, l’ensemble des données publiques d’internet ont été déjà été utilisées. Rien ne sert de faire grossir les IA si nous n’avons pas de quoi les nourrir. Pour l’entrainement des futurs modèles, de nouvelles données générées elles-mêmes par les IA seront utilisées.IA Générative : des difficultés croissantes pour la mise au point des nouveaux modèles

De ce fait, on constate un certain retard et nombres de difficultés pour mettre au point les nouvelles générations de modèles. Ainsi OpenAI peine à sortir la version 5 de ChatGPT qui avait été annoncée initialement pour fin 2024. Selon un rapport de The Information, les gains en qualité réalisés avec la nouvelle version sont bien plus modestes que ceux observés lors de la transition entre GPT-3 et GPT-4. Le ralentissement de l’amélioration des performances pourrait s’expliquer par la difficulté croissante de trouver des données d’entraînement de haute qualité. Ainsi, chatGPT 4.5 sorti en mars 2025, déçoit. En effet cette version, bien qu’apportant des améliorations intéressantes, reste dans la lignée des précédentes versions et ne propose aucune fonctionnalité vraiment nouvelle. OpenAI a clairement mis l’accent sur l’intelligence émotionnelle plutôt que sur la pure puissance analytique. Une IA plus « humaine » : de nombreux testeurs notent que cette version est plus fluide, plus naturelle, et moins robotique dans ses échanges. Cependant, si tout est “un peu mieux”, on est loin d’une transformation radicale.IA Générative : un impact majeur sur l’environnement

Comment le secteur de l’IA générative peut-il encore croître à un rythme si effréné ? Alors que l’année 2025 débute, les investissements en IA générative semblent défier toutes les attentes. Dans un monde ou le dérèglement climatique se fait partout de plus en plus sentir, l’IA continue à se développer à un rythme insoutenable avec des impacts environnementaux de plus en plus important ! Impact sur la pollution au CO2 mais également sur l’eau. En effet, les calculs nécessaires à l’entraiment et au fonctionnement des modèles mobilisent énormément de serveurs qui dégagent alors de la chaleur. Il faut donc une énorme quantité d’eau pour refroidir les salles machine. Or, aux Etats Unis par exemple, les datacenters sont souvent situés dans des endroits déserts comme l’Arizona et l’Iowa, ce qui accentue le stress hydrique déjà présent. Avec la demande croissante en IA, le développement de datacenters a été multiplié par 7 en deux ans à Los Angeles, aggravant également la pression sur les ressources hydriques dans une région déjà touchée par une sécheresse prolongée. À l’échelle mondiale, les centres de données hébergeant l’IA devraient consommer six fois plus d’eau que le Danemark. D’ici 2027, l’IA pourrait utiliser jusqu’à 6,6 milliards de mètres cubes d’eau.IA Générative : les axes de développement pour les années à venir

Plusieurs approches vont coexister concernant le développement de l’intelligence artificielle : La première, celle actuellement adoptée par les leaders et en premier lieu OpenAI, consiste à poursuivre la course à la puissance pour le développement d’une IA généraliste basée sur toujours plus de ressources avec les impacts que nous avons évoqués précédemment. La seconde consiste à aller vers une IA plus frugale, à savoir une IA utilisant moins de ressources pour son entraînement et son fonctionnement et avec un impact plus raisonnable sur l’environnement.Toujours plus de ressources pour une IA généraliste surpuissante

Clairement, la course à l’IA ne va pas s’arrêter. L’IA c’est l’arme économique et politique de demain et toutes les grandes puissances, Etat Unis et Chine en premier lieu, se livrent à une course effrénée pour être leader dans le domaine. La guerre des IA aura bien lieu pour dominer le marché. C’est la stratégie clairement affichée d’OpenAI qui malgré une perte abyssale de 5 milliards de dollars en 2024 continue à lever massivement des fonds et à investir. Dans son discours de début d’année, Sam Altman, le PDG d’OpenAI vient d’annoncer que désormais, leur objectif ne sera plus de construire une IA Générale mais une super intelligence qui dépasse les capacités humaines. L’objectif principal étant d’accélérer drastiquement la recherche scientifique en faisant de nouvelles découvertes. Côté américain, la course à la puissance continue. De l’aveu de Sam Altman lui-même, la nouvelle version 4.5 de chatGPT nécessite une infrastructure gigantesque : « bad news: it is a giant, expensive model ». Même chose chez Elon Musk qui a mis en place, à marche forcée, un cluster de 200 000 GPU, pour l’entrainement de son modèle Grok 3. Cette nouvelle IA a été présentée début 2025 pour concurrencer chatGPT 4. Selon Elon Musk, ce modèle a été entraîné avec dix fois plus de puissance de calcul que son prédécesseur. Son super calculateur, Colossus, est présenté comme étant un cluster IA parmi les plus puissants du monde :- Colossus, le fleuron de xAI, est un cluster d’entraînement composé de 100 000 GPU H100 de Nvidia

- Colossus devrait doubler de taille dans les prochains mois

- 100 000 GPU supplémentaires seront ajoutés, dont les très attendus H200