L’intelligence artificielle est l’une des technologies clé de la quatrième révolution industrielle. À l’heure actuelle, il est estimé que le marché de l’IA en termes de cybersécurité passera de 1 milliard de dollars à 34,8 milliards de dollars d’ici 2025. Selon la CNIL, l’intelligence artificielle tient plutôt du domaine scientifique, dans lequel des outils peuvent être classés lorsqu’ils respectent certains critères.

Pour le Parlement européen, l’intelligence artificielle représente tout outil utilisé par une machine afin de « reproduire des comportements liés aux humains, tels que le raisonnement, la planification et la créativité ». Les données restent cependant modestes en particulier à cause du manque de recul sur le sujet. De plus, l’évolution très rapide du développement de l’IA rend l’analyse des données très subjective.

Si l’IA est utilisée comme facilitateur du quotidien, elle pose cependant de nombreuses questions en termes de sécurité. La reconnaissance faciale qui sera utilisée pour les Jeux Olympiques de Paris 2024 a notamment été pointée du doigt au sujet de la protection de la vie privée. Au-delà de ces utilisations publiques de l’intelligence artificielle, ce sont les opportunités commerciales qui se multiplient. En effet, les articles détaillant les avantages de l’intelligence artificielle, notamment pour la cybersécurité, se multiplient : aide au quotidien, traitement massif de données, outils contre les cyberattaques…

Qu’en est-il réellement ? La cybersécurité se définissant comme l’ensemble des moyens utilisés pour assurer la sécurité des systèmes et des données informatiques d’un État ou d’une entreprise, on peut se demander si les entités intégrant l’IA dans leur processus de cybersécurité ont raison. L’IA est-elle réellement le nouvel outil indispensable de la cybersécurité aux opportunités multiples, ou bien les risques encourus face à cette nouvelle technologie, pour laquelle nous ne disposons d’aucun recul, sont-ils trop élevés ?

L’IA est un outil efficace pour une cybersécurité plus efficace notamment au regard de la cyberdéfense des organisations aussi bien d’un point de vue organisationnel, pour l’attribution des ressources ou la protection des données, que pour des méthodes plus spécifiques telles que la réponse à incident ou la gestion de la menace cyber.

Enfin, considérée par beaucoup comme un outil qui façonnera les nouvelles cyberattaques de demain, on peut se demander en quoi l’intelligence artificielle sera un outil pour les attaquants.

L’IA un nouvel outil pour une cybersécurité plus efficace

L’IA dans la gestion de la menace et des incidents

L’intelligence artificielle (IA) permet de traiter un important volume de données et ce en continu 24h/24, 7j/7. Ainsi, elle peut détecter de nouveaux risques de sécurité, d’autant plus que les algorithmes apprennent au fur et à mesure afin d’éviter les procédures répétitives. Ces capacités décuplées permettent donc d’améliorer certains aspects de la cybersécurité.

L’intelligence artificielle décharge notamment l’humain de certaines tâches chronophages. Rappelons que l’erreur du facteur humain est l’une des causes principales des risques en termes de cybersécurité (90% des incidents de cybersécurité). Ces avantages sont utiles pour les processus de gestion des incidents mais aussi de la menace, par exemple pour la détection d’activités anormales (développer l’exemple des deep fakes), l’identification d’activités inhabituelles et la prévention de l’exploitation des failles.

La gestion de la menace consiste à collecter un grand nombre d’informations de façon précise sur la menace et à les rendre opérationnelles pour mieux contrer les attaques. Pour cela les informations doivent être pertinentes et structurées. Les informations recueillies permettront d’apporter une réponse appropriée et plus rapide face aux malwares. Ainsi l’IA permettra de faire face à la surcharge informationnelle actuelle et de traiter les informations rapidement et efficacement.

Dans le cadre de la réponse à incident, l’intelligence artificielle pourrait également prendre de l’importance. La réponse à incident comprend plusieurs étapes, une fois la notification de l’incident reçue, cette dernière sera analysée puis un plan de restauration sera mis en place puis appliqué. Il existe dans ce processus de nombreuses tâches pouvant être en partie automatisées, par exemple, la réinstallation d’antivirus, la vérification de clés de registre ou encore la modification de règles dans les firewalls.

Initialement, les plateformes de réponse aux incidents (ou SOAR) proposent des scénarios de réponse automatique (ou semi-automatique) pour faciliter l’enchaînement des tâches, mais depuis l’apparition des technologies d’intelligence artificielle on constate une réelle amélioration de la priorisation et la mise en place des réponses. Cette automatisation n’inclut cependant pas le raisonnement humain, permettant de contextualiser les choix selon les objectifs. A l’heure actuelle ce manque n’a pas été comblé, mais les capacités croissantes de machine learning des intelligences artificielles seront potentiellement en mesure de le faire à moyen terme. Pour l’heure, l’IA remplit surtout un objectif d’efficacité.

Enfin, les tests d’intrusion qui permettent de déceler les vulnérabilités au cœur du système d’information pour les exploiter. Les choix possibles étant bien trop conséquents, la totalité des vulnérabilités ne peut être traitée par un humain, l’intelligence artificielle apparaît donc comme un appui potentiel notamment avec ses capacités de machine learning.

Encore une fois l’IA ne diminue cependant pas le besoin d’expertise d’analyse une fois les informations collectées, mais ses capacités permettront à une entité d’être plus efficace dans sa globalité.

L’IA pour la gestion des données

La gestion des données est un enjeu contemporain capital de la cybersécurité. Face aux flux massifs d’informations il est impératif d’être en mesure de gérer et de protéger ces données. La gestion des données permettra une optimisation de l’utilisation des données dans les processus de sécurité. Quant à la protection des données, primordiale dans la mesure où il s’agit d’un capital majeur pour une entreprise, l’IA permettra de cartographier, référencer, sauvegarder, chiffrer les données.

Afin qu’une société puisse s’acquitter de ses obligations en vertu du RGPD, Le développement des outils de gouvernance et de gestion des risques jouent un rôle particulièrement important dans la conformité des entreprises face au RGPD.

Ainsi, deux types de mesures doivent être adoptées. D’une part, des mesures techniques incluant le déploiement de technologies permettant de protéger et d’arbitrer l’accès aux systèmes informatiques d’une entreprise ; d’autre part des mesures organisationnelles impliquant des processus de contrôle concernant les tierces personnes amenées à manipuler les données de l’entreprise. Il est évident qu’un individu ne peut pas accomplir toutes ces tâches en autonomie, l’intelligence artificielle apparaît donc comme un atout améliorant la performance et la compétitivité, notamment car elle répond aux besoins de manière anticipative.

D’autre part, toujours dans le cadre des données personnelles et du RGPD, des algorithmes d’IA peuvent participer aux différentes tâches à effectuer telles que la cartographie des données collectées, l’identification des données nécessaires à l’activité de l’entreprise, ou encore leur sécurisation. Se pose toutefois la question de la confiance en l’IA pour traiter de telles données. Cette problématique se manifeste tout particulièrement pour les algorithmes utilisés dans l’analyse, la compréhension et l’anticipation des comportements de certains consommateurs. Grâce aux données collectées à l’aide des cookies, il est possible de comprendre un individu et de l’orienter en fonction. La Chine utilise aussi des données personnelles pour effectuer un “système de crédit social” (scoring) des personnes grâce à de l’IA qui indique va noter les citoyens selon des critères précis basés sur leur statut économique et social.

Ces mécanismes utilisés dans des entreprises telles que Google et Amazon soulèvent des problèmes éthiques : quelles limites peut-on accorder à l’utilisation de l’IA au regard de l’exploitation des donnée personnelles ? La proposition de Règlement sur l’IA rendue par la Commission Européenne tente d’y répondre avec une approche fondée sur une échelle de risques en fonction de l’usage du système d’IA.

Des limites existent à l’utilisation de l’intelligence artificielle dans la protection des données particulièrement sur l’éthique mais également dans le cas où le droit limite l’usage de l’IA dans le cadre du traitement de données. Cependant les régions du monde non soumises aux textes législatifs auront un potentiel de R&D plus important.

Une nouvelle arme pour les attaquants: l’IA façonne les cyberattaques

Des cyberattaques augmentées grâce à l’IA

Cela fait plusieurs années que l’IA est utilisée à des fins de malveillance par les cybercriminels. L’usage de l’intelligence artificielle permet d’améliorer des techniques d’attaques déjà utilisées telles que la personnification, le spearphishing, la target selection ou le persona building1. Connu de tous, l’hameçonnage (phishing) est aujourd’hui de plus en plus efficace grâce aux technologies d’IA disponibles pour générer de façon automatique de fausses informations telles que des vidéos, des articles, des messages ou encore des données personnelles2. Cela est possible grâce à une ingénierie sociale qui peut être automatisée en une veille pour identifier les cibles les plus vulnérables à l’aide des données issues des réseaux sociaux. En effet, grâce aux données collectées sur une personne, l’IA peut générer un site web malveillant, mais également des spams personnalisés crédibles donc plus difficilement détectables par les utilisateurs.

D’autres attaques utilisent l’IA pour usurper des identités. S’appuyant sur des injections biométriques3, le logiciel de reconnaissance faciale reçoit la donnée corrompue est va la désigner comme authentique. Cette menace est de plus en plus répandue comme l’explique Alan Tussy (CEO de FaceTec)4 car “Bien que l’attaque paraisse complexe, elle n’est en réalité pas si difficile dès lors que les logiciels de deepfakes sont facilement accessibles et souvent gratuits.”

Un des exemples les plus répandus d’utilisation de l’IA à des fins malveillantes est celui des deepfakes. Cette technique consiste à utiliser le machine learning pour produire de fausses vidéos les plus réalistes possible. Elle a notamment été utilisée en Ukraine pour des opérations psychologiques (psy-ops) dans le cadre d’une campagne de désinformation à grande échelle. Le deep fake est également utilisé pour de l’usurpation d’identité. Cette pratique s’est accentuée pendant la pandémie du Covid19 où les cybercriminels ont eu accès à de nombreuses données biométriques grâce aux visioconférences5 : une simple photo suffit pour créer une nouvelle photo grâce au “morphing”6.

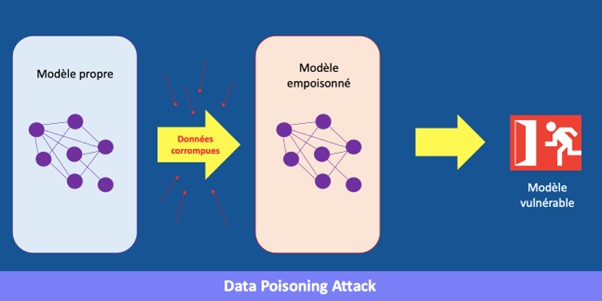

De nouvelles méthodes d’attaques grâce à du “dopage d’IA” ont pu être identifiées. Omniprésentes dans notre vie de tous les jours, le machine learning permet d’orienter au mieux les recommandations faites aux internautes grâce aux données recueillies sur nos préférences. Ces robots sont toutefois pris pour cible dans des cyberattaques. En effet, conçu pour altérer les prédictions d’un système de machine learning, l’empoisonnement des données7 (Data poisoning attack), rendu possible grâce aux algorithmes d’intelligence artificielle, a pour objectif de corrompre un ensemble de données exploité pour entraîner l’IA. La dangerosité de l’attaque s’observe dans les possibilités d’influencer l’IA en lui injectant subtilement des scénarios allant dans le sens souhaité. Il est d’ailleurs impossible de remédier à ce type d’attaque lorsque les données corrompues ont été injectées, rendant dès lors le travail de l’IA perdu. Cette attaque est souvent utilisée pour paralyser les mesures de cybersécurité d’une entreprise en brouillant la précision du système de protection qui ne sera plus dès lors en mesure de détecter certaines failles de sécurité sur le réseau. Une fois la détection altérée, il est alors aisé pour les attaquants de déployer un ransomware sur le réseau visé !