Deepfakes : révélateurs de nos vulnérabilités cognitives

Comment les deepfakes exploitent nos vulnérabilités psychologiques et transforment notre rapport à la vérité ? Cette analyse fait écho à la conférence de Data.IA de Nantes « Plongée dans l’univers des deepfakes »

En mars 2024, un cadre supérieur d’une multinationale énergétique britannique reçoit un appel urgent de son PDG allemand. La voix lui est familière, le ton pressant, les instructions claires. Il doit transférer immédiatement 243 000 dollars à un fournisseur hongrois, avec promesse de remboursement rapide. L’employé obéit avant de découvrir le pot aux roses. Catastrophe ! Il s’agissait d’une voix clonée par IA à partir d’enregistrements publics1. La note de ce deepfake audio est plutôt salée.

Ne croyons pas que cette arnaque soit un cas isolé. Le FBI avait déjà prévenu en septembre 2024 d’une hausse rapide de ces fraudes2. Dans la foulée, les banques comme Starling Bank avaient tiré la sonnette d’alarme. Des millions de personnes pourraient être visées dans les années à venir3. Depuis 2024, 28 % des adultes britanniques pensent avoir été la cible d’une arnaque au clonage vocal par IA au cours de l’année écoulée4.

Les deepfakes, ces contenus synthétiques ultraréalistes générés par des algorithmes d’apprentissage automatique, ne se limitent pas à l’audio. Ils englobent également la vidéo et l’image, sapant la confiance publique et les marchés.

Outre les deepfakes audio, les deepfakes vidéo sapent également la confiance publique et les marchés. Ainsi, en mars 2022, les réseaux sociaux ukrainiens et la chaîne de télévision nationale Ukraine 24 diffusaient un « message » du président Volodymyr Zelensky. Ce dernier, face caméra, appelait à la reddition face à la Russie5. Certes, le deepfake, rapidement éventé, s’avérait bien grossier. Nous étions alors en 2022. La manipulation médiatique constitue le lot des communications en temps de guerre. Mais ce précédent marquait un tournant en attaquant la perception de la réalité avec l’IA.

Autre format de deepfake au service de la désinformation, l’image. En mai 2023, une photographie représentait le Pentagone enveloppé de fumée6. Sa diffusion a brièvement ébranlé de 0,3 % les marchés financiers américains7. Il constitue à cet égard « le premier cas d’image générée par intelligence artificielle ayant influé sur la Bourse8 ».

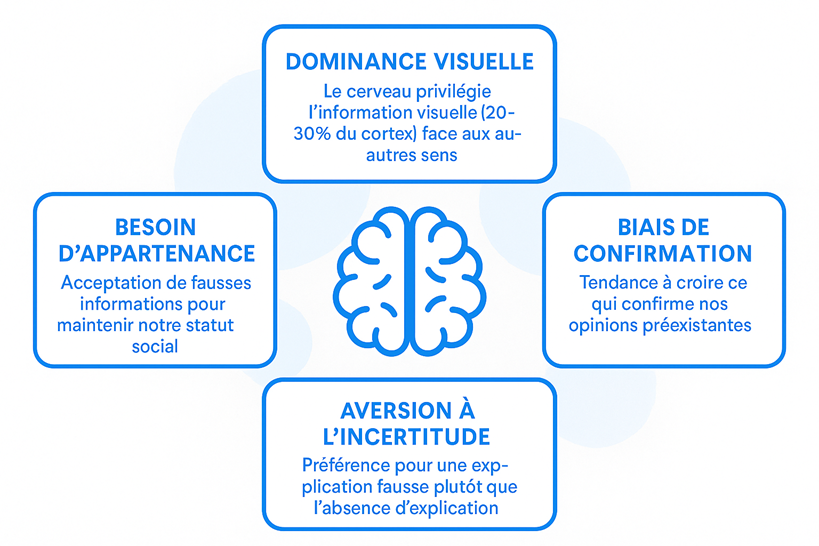

Mais pourquoi tombons-nous si facilement dans le piège ? La réponse se trouve dans le fonctionnement même de notre cerveau et, plus troublant encore, dans notre besoin psychologique profond de croire.L’effet de dominance visuelle

Vous êtes-vous déjà demandé pourquoi une vidéo vous convainc plus qu’un texte ? La réponse réside dans une caractéristique fondamentale de notre cerveau. Nous sommes des êtres visuels avant tout. Mais surtout, nous sommes des êtres qui veulent croire.

Les deepfakes agissent comme un révélateur chimique sur notre civilisation de l’image. Ils mettent à nu une réalité dérangeante. Notre société a érigé le visuel en ultime critère de vérité.

Cette dépendance n’est pas seulement neurologique. Elle est également profondément psychologique. Les recherches en neurosciences, confirmées par des études d’imagerie par résonance magnétique fonctionnelle, révèlent ce que les psychologues nomment l’ « effet de dominance visuelle » de Colavita.

Face à des stimuli multisensoriels, notre cerveau privilégie systématiquement l’information visuelle. Il mobilise en effet environ 50% de notre cortex contre seulement une fraction pour l’audition11.

Notre cerveau privilégie l’information visuelle (30% du cortex). En outre, nos besoins fondamentaux de croyance, d’appartenance et de confiance induient des vulnérabilités cognitives que la technologie deepfake exploite systématiquement.

Mais il y a plus troublant encore. Notre psychologie nous incite activement à adhérer aux images que nous percevons. Et surtout quand cela conforte nos attentes ou nos désirs. Les psychologues appellent cela le biais de croyance motivée. Nous avons un besoin psychologique profond de croire en certaines vérités. Cela est particulièrement vrai pour celles qui confirment notre vision du monde, notre identité ou nos espoirs.

Concrètement, qu’est-ce que cela signifie pour vous ? Prenons un exemple. Face à une vidéo qui fait écho à vos convictions politiques, légitime vos craintes ou nourrit vos espérances, votre cerveau opère un double mécanisme. Il attribue spontanément plus de véracité à ces images. Plus encore, il développe un désir de les considérer comme authentiques. Un deepfake est susceptible d’exposer un adversaire politique dans une situation compromettante. C’est que la psychologie et la technologie conspirent pour déjouer tous mécanismes de défense critique.

Le besoin humain de croire

Pourquoi notre esprit veut-il tant croire ? Cette vulnérabilité n’est pas un défaut. Elle constitue une caractéristique évolutive qui nous a longtemps servi. Croire rapidement aidait nos ancêtres à réagir rapidement face au danger. Accorder notre confiance aux membres de notre tribu renforçait la cohésion sociale. Ces mécanismes subsistent encore aujourd’hui, mais dans un contexte où ils deviennent des failles exploitables.

Les trois piliers de notre vulnérabilité psychologique

Les deepfakes exploitent particulièrement trois besoins psychologiques fondamentaux. Cela inclut le besoin de cohérence, le besoin d’appartenance et le besoin de sens.

Le besoin de cohérence : fuir l’incertitude

D’abord, notre cerveau déteste l’incertitude et les contradictions. Face à une vidéo qui semble réelle, même si une petite voix intérieure doute, nous préférons souvent résoudre cette dissonance en acceptant ce que nous voyons. C’est moins épuisant mentalement que de maintenir le doute.

Le besoin d’appartenance : croire pour rester dans le groupe

Ensuite, quand un deepfake circule dans notre groupe social et que tout le monde semble y croire, notre besoin d’appartenance nous pousse à l’accepter aussi. Douter reviendrait à s’isoler socialement, ce que notre psychologie évite instinctivement.

Le besoin de sens : comprendre à tout prix

Enfin, les deepfakes qui expliquent des événements complexes ou mystérieux satisfont notre besoin de comprendre le monde. Une vidéo truquée qui révèle une conspiration s’avère psychologiquement plus satisfaisante que d’accepter l’incertitude ou la complexité du réel.

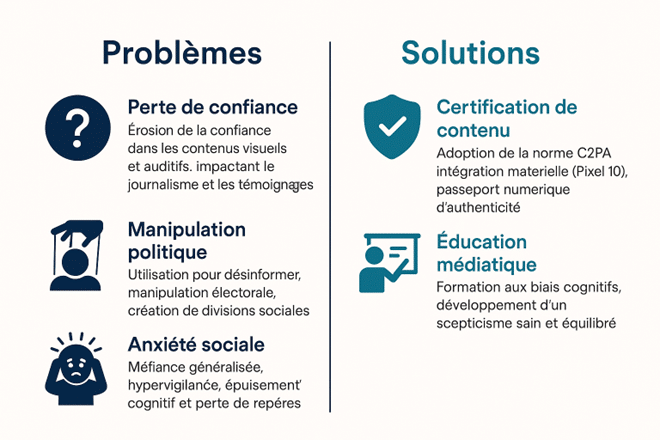

Une faille exploitée : l’érosion de la confiance et du réel

Cette menace épistémique, l’incapacité croissante à distinguer le vrai du faux, érode la confiance sociale. Elle transforme en outre le scepticisme sain en paranoïa généralisée12.

Ces mécanismes psychologiques profonds ne fonctionnent pas en isolation. Ils s’entremêlent et se renforcent mutuellement. Ils tissent un réseau complexe de vulnérabilités que les créateurs de deepfakes ont appris à exploiter avec une précision chirurgicale. Examinons maintenant comment ces failles spécifiques se manifestent dans notre quotidien numérique.

Les pièges psychologiques qui nous rendent vulnérables

Paradoxe de la méfiance, paréidolie numérique, biais de confirmation, illusion de compétence, heuristique du réalisme… Comprendre ces mécanismes, c’est déjà commencer à s’en protéger. Les principales failles cognitives et psychologiques que les deepfakes exploitent dans notre psyché sont autant d’héritages évolutifs détournés.

Paradoxe de la méfiance : quand savoir rend plus vulnérable

Avez-vous déjà douté de l’authenticité d’une vraie vidéo après avoir appris l’existence des deepfakes ? Vous n’êtes pas seul.

Cette découverte récente en psychologie cognitive révèle un paradoxe troublant. Notre connaissance des deepfakes peut altérer notre perception de la réalité authentique. Mais paradoxalement, notre besoin de croire demeure si fort que nous oscillons entre méfiance excessive et crédulité dangereuse.

Paréidolie numérique : voir ce qu’on veut voir

Vous connaissez cette sensation de reconnaître un visage dans les nuages ? C’est de la paréidolie classique.

Sa version numérique s’avère plus insidieuse. Votre cortex de reconnaissance faciale impose des schémas familiers sur des données ambiguës.

Pire encore, quand nous voulons voir quelque chose ou quelqu’un, notre cerveau remplit activement les blancs pour créer ce que nous espérons voir.

Biais de confirmation : croire pour conforter ses croyances

Quand vous voulez croire quelque chose, trouvez-vous toujours des preuves pour vous conforter ? Le biais de confirmation trouve dans les deepfakes un terrain particulièrement fertile. Notre psychologie ne se contente pas de chercher des preuves qui confirment nos croyances. Elle nous pousse à vouloir que ces preuves soient vraies, créant une double vulnérabilité.

L’illusion de compétence : « Moi, je saurais faire la différence »

Pensez-vous pouvoir détecter un deepfake à l’œil nu ?

En 2021, des recherches révèlent une statistique alarmante. 67,4% des participants jugent les vidéos authentiques même quand ils sont informés que 50% sont des deepfakes13. Notre désir de croire en notre propre compétence amplifie cet excès de confiance.

L’heuristique du réalisme : la confiance héritée de l’évolution

Notre cerveau, évolutivement programmé pour éviter les fausses alarmes coûteuses, privilégie systématiquement l’hypothèse d’authenticité. Mais il y a plus. Nous voulons que les choses soient vraies, surtout quand elles correspondent à nos attentes émotionnelles.

L’heuristique du réalisme repose sur des millions d’années d’évolution cognitive pendant lesquelles nos ancêtres ont forgé une confiance justifiée en l’information visuelle directe.

Cette programmation neurologique persiste, renforcée par notre besoin psychologique de faire confiance pour fonctionner socialement.

« Le dividende du menteur »: la vérité renversée

Les deepfakes inversent la séquence traditionnelle de vérification, instaurant ce que les juristes Chesney et Citron ont nommé le « liar’s dividend14» (le dividende du menteur).

Notre psychologie, qui cherche la cohérence, s’adapte à cette inversion en rationalisant après coup ce qu’elle a déjà accepté émotionnellement.

L’état de l’art technologique en septembre 2025

La course entre créateurs et détecteurs de deepfakes s’intensifie, avec des innovations constantes des deux côtés.

D’une part, les systèmes existants continuent d’affiner l’identification des contenus synthétiques après leur diffusion.

D’autre part, de nouvelles initiatives se tournent vers la provenance et l’authentification en amont. Elle ouvre ainsi la voie à une protection préventive et intégrée.

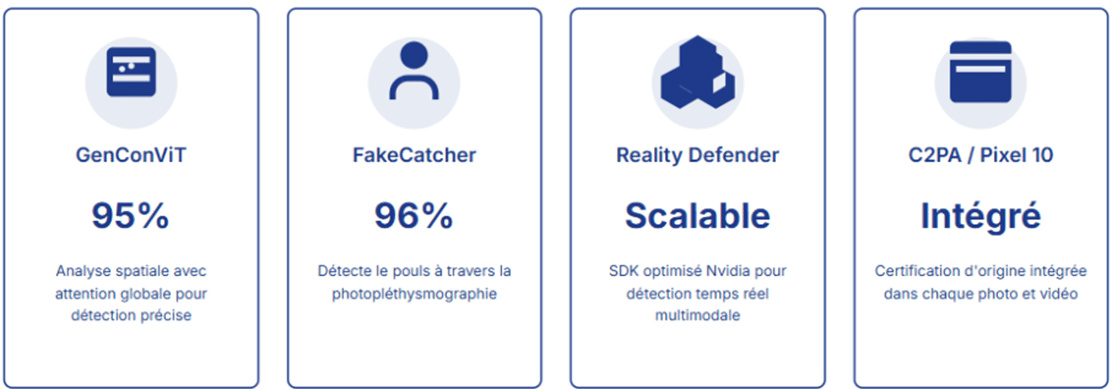

GenConViT, Deepfake-Eval, FakeCatcher, Reality Defender : des approches de détection des deepfakes

En septembre 2025, le paysage de la détection des deepfakes atteint une maturité inédite. Après plusieurs années de rivalité entre créateurs et détecteurs, quatre approches dominent désormais la scène technologique mondiale. Chacune illustre une philosophie distincte.

L’approche GenConViT repose sur l’analyse neuronale par attention globale. L’étude comparative Deepfake-Eval-2024 évalue la robustesse des modèles dans des conditions réelles. Intel FakeCatcher se fonde sur la détection biologique en temps réel. Reality Defender, enfin, privilégie une approche multimodale et contextuelle. Par conséquent, la détection des contenus synthétiques s’oriente désormais vers une authentification intégrée15.

GenConViT : analyse neuronale pour l’intelligence visuelle

L’approche GenConViT représente l’état de l’art actuel. En combinant l’analyse spatiale avec l’attention globale, cette méthode atteint plus de 95% de précision sur les benchmarks académiques16.

Mais attention aux chiffres trompeurs ! Une découverte de l’équipe du Georgia Institute of Technology a bouleversé le domaine. Une méthode de référence simple peut atteindre 81% de précision. Elle rivalise ainsi avec les détecteurs commerciaux les plus avancés17.

Deepfake-Eval : validation empirique pour la robustesse

L’étude comparative Deepfake-Eval-2024 apporte une désillusion cinglante. Elle révèle que les modèles open-source s’effondrent considérablement lorsqu’ils sont confrontés aux contenus non maîtrisés du monde réel. Ils accusent, en effet, une dégradation moyenne de 50% pour la vidéo18.

FakeCatcher : détection biologique pour l’authenticité humaine

Intel FakeCatcher représente une approche révolutionnaire. Au lieu d’analyser les défauts visuels, cette technologie utilise la photopléthysmographie19 à distance pour détecter votre pouls à travers la caméra.

L’idée est intéressante. Les vrais humains ont des signaux biologiques cohérents que les deepfakes ne peuvent pas parfaitement reproduire. Intel revendique 96% de précision en temps réel20.

Le problème ? Cette technologie est hypersensible à l’éclairage, à la compression vidéo, au maquillage, et aux deepfakes de haute qualité.

Tandis qu’Intel mise sur les signaux biologiques, d’autres acteurs adoptent des stratégies radicalement différentes, reconnaissant qu’aucune approche unique ne peut suffire face à la diversité des menaces.

Reality Defender : vérification multimodale et de provenance pour la confiance intégrée

Reality Defender adopte une approche plus pragmatique avec des ensembles multimodaux qui analysent simultanément l’image, l’audio et le contexte.

En août 2025, l’entreprise lancé des SDK optimisés Nvidia. Ces derniers assurent une détection à grande échelle en temps réel21.

La prévention par la provenance : l’authenticité intégrée dès la création

Après les approches centrées sur la détection des deepfakes, on passe d’une logique de réaction à une logique de prévention. Cette évolution traduit un basculement stratégique. Il s’agit désormais de certifier l’origine et de tracer le cycle de vie de chaque image, vidéo ou enregistrement sonore.

Content Credentials C2PA : le passeport numérique de Google Pixel 10

L’année 2025 marque, à ce propos, un tournant historique avec l’adoption massive de la provenance au niveau matériel.

Le Google Pixel 10, lancé en septembre 2025, intègre par défaut les Content Credentials C2PA. C’est un standard international. Il vise à garantir la traçabilité et l’authenticité des contenus numériques tels que les images, vidéos, sons, textes, etc22.

Imaginez un passeport numérique inviolable pour chaque photo ou vidéo. Il contient l’identité du créateur, la date, l’appareil utilisé, et l’historique complet des modifications.

Cette approche préventive par la certification trouve son complément nécessaire dans les solutions de détection en temps réel. C’est particulièrement crucial pour les communications professionnelles où l’authenticité immédiate est vitale.

GetReal Security : vigilance en temps réel contre les deepfakes audio et vidéo

L’entreprise de cybersécurité GetReal Security étend sa détection en temps réel.

La solution outille les équipes informatiques et de sécurité pour détecter, investiguer et réagir dès qu’une identité trompeuse apparaît dans une réunion virtuelle. Cette identité trompeuse s’apparente à un deepfake audio ou vidéo.

Elle cible particulièrement les plateformes de visioconférence les plus utilisées. Citons entre autres, Microsoft Teams et Cisco Webex23.

Aurigin.ai : détection des deepfakes audio avec Apollo

Aurigin.ai, jeune pousse suisse spécialisée dans la détection de deepfakes audio, a lancé Apollo. Ce système allie rapidité et précision dans plus de 40 langues23.

Ce système offre une détection ultra rapide, avec un taux de précision supérieur à 98 %24. Il est conçu pour protéger les communications critiques (conférences, l’authentification vocale, prévention de fraudes financières).

Il garantit, en outre, les données analysées demeurent sur les serveurs du client pour respecter les politiques de confidentialité.

Aitana Lopez : un faux numérique capitalisant 300000 followers

L’exemple d’Aitana Lopez illustre parfaitement cette dérive. Cette influenceuse espagnole aux plus de 380 000 followers Instagram n’existe pas. Elle est entièrement générée par IA, gagne plus de 11 000 dollars par mois, et influence les choix de vrais humains25.

Notre besoin de connexion humaine est-il si fort que nous préférons croire en l’authenticité d’une IA plutôt que d’accepter notre solitude ?

Votre visage et votre voix ne vous appartiennent plus exclusivement. Ils se muent en données appropriables, manipulables, détournables. Cette marchandisation de l’apparence soulève des questions inédites sur la propriété de soi dans l’espace numérique.

Deepfakes et illusions esthétiques : le nouveau visage du désirable

Cette crise s’accompagne d’un phénomène plus pernicieux. Les algorithmes génératifs, entraînés sur des datasets biaisés, reproduisent et amplifient les stéréotypes de beauté. Une spirale s’enclenche alors. Elle standardise nos représentations du désirable. Face à cette perfection virtuelle, les jeunes générations développent des complexes face à un idéal par essence inatteignable.

L’impact des deepfakes sur la démocratie

L’irruption des deepfakes dans l’arène politique ne modifie pas seulement les règles du jeu démocratique. Elle exploite notre besoin psychologique de croire en nos leaders et nos institutions26.

Quand la manipulation survit à la vérité

Les études récentes révèlent un pouvoir de conviction préoccupant.

Environ 42 % du public américain peut, en effet, être convaincu de scandales politiques entièrement fabriqués via des deepfakes bien construits. Ce taux est similaire à celui observé pour les fausses informations audio (44 %) ou textuelles (42 %). Ces résultats proviennent d’une étude expérimentale menée sur un échantillon représentatif national de 5 724 Américains27.

Plus troublant encore, cet effet persiste même après révélation de la supercherie. C’est parce que notre psychologie résiste à abandonner une croyance dans laquelle nous avons investi émotionnellement. Cette résistance se manifeste surtout lorsque cette croyance renforce nos convictions partisanes préexistantes.

D’ailleurs, le raisonnement motivé par l’appartenance politique constitue le facteur le plus puissant dans l’acceptation ou le rejet d’informations. Par exemple, 50% des Républicains ont cru qu’une vidéo authentique d’Obama était réelle contre seulement 21% des Démocrates28. En revanche, seuls 58% des Démocrates ont reconnu comme authentique un discours réel de Trump sur le COVID-19, contre 81% des Républicains29.

C’est la sophistication croissante des technologies de synthèse vidéo qui amplifie cette vulnérabilité cognitive. Celle-ci menace la confiance démocratique dans les institutions médiatiques. Par conséquent, elle fragmente la société en tribus épistémiques incapables de s’accorder sur une réalité factuelle commune.

La fracture démocratique face aux deepfakes

Les citoyens les plus informés détectent mieux les manipulations, mais cette compétence crée un fossé démocratique.

Notre besoin d’appartenance nous pousse à croire ce que notre groupe social accepte, fragmentant la société en tribus épistémiques.

L’égalité citoyenne devant l’information se fracture entre ceux qui peuvent décoder la désinformation et ceux qui la subissent.

Le deepfake : la désinformation à grande vitesse

En 23 janvier 2024, se tenait la primaire démocrate du New Hampshire. Juste avant cette dernière, des milliers d’électeurs démocrates ont reçu un appel robotisé (« robocall ») falsifié grâce à l’IA30.

Dans cet audio, un « Biden » déclarait : « Nous savons l’importance de voter démocrate quand nos votes comptent. Il est important que vous gardiez votre vote pour l’élection de novembre. »

Ce deepfake visait à décourager la participation à la primaire. Il s’est propagé rapidement via des appels téléphoniques automatisés. Il a touché des milliers de personnes en quelques heures seulement.

Ainsi, le temps devient l’ennemi. Un deepfake peut influencer des millions de personnes avant même qu’une correction ne soit apportée. Cette vitesse de propagation, incompatible avec le temps de la vérification, transforme chaque élection en course contre la montre informationnelle.

Microciblage et deepfakes : le talon d’Achille de de notre discernement

En 2024, des bots contrôlés par la Chine (liés à l’opération « Spamouflage ») ont diffusé du contenu négatif sur la plateforme X (anciennement Twitter). Ils ciblaient le sénateur républicain Marco Rubio de Floride. Ce contenu, généré ou amplifié par l’IA, visait à semer la discorde sur des thèmes comme l’économie, la censure et l’immigration. Ce microciblage contribue ainsi à diffuser des deepfakes spécifiquement conçus pour des groupes démographiques particuliers, ici, les électeurs de Floride, pour maximiser leur impact émotionnel31.

Cette personnalisation de la désinformation engendre des bulles de fausseté. Chaque communauté est alors exposée à une version différente d’une même réalité manipulée. Ces attaques ciblées contre nos processus démocratiques ne représentent que la partie émergée de l’iceberg. Notre capacité collective à démêler le vrai du faux s’érode inexorablement.

L’apocalypse épistémique et le besoin de certitude

L’effet le plus pernicieux des deepfakes réside dans leur capacité à éroder la confiance collective dans l’information visuelle.

Peu à peu, nous cessons de croire ce que nous voyons. Cette crise épistémique, autrement dit crise de la connaissance, mettrait à rude épreuve notre besoin psychologique fondamental de certitude.

Ce n’est pas sans conséquence sur notre discernement. Aussi, certains s’enferment dans un déni de la menace pour préserver leur équilibre. D’autres développent une hypervigilance, doutant de tout, au prix d’une anxiété épuisante32.

La preuve visuelle en sursis…

Concrètement, cette crise de confiance pourrait mener à une société où la preuve visuelle perd progressivement son autorité. On peut comprendre dès lors que les vidéos deviendront fragiles juridiquement et moralement.

Les témoignages oculaires deviendront suspects. La vérification deviendra un réflexe permanent et épuisant. Et pour finir, la confiance sociale s’érodera33.

Et nous l’avons évoqué. Le concept du liar’s dividend (« le dividende du menteur ») illustre ce basculement. Dès lors qu’il est possible d’affirmer qu’une vidéo est truquée, toute preuve audiovisuelle peut être contestée, même lorsqu’elle est authentique34.

Dans certains procès récents, des avocats ont déjà soutenu qu’une vidéo réelle pouvait être un deepfake35. Cette évolution poussera dorénavant les tribunaux à exiger des procédures d’authentification renforcées.

Pour la justice, les défis deviennent particulièrement aigus. Comment un juge peut-il évaluer une preuve vidéo quand son propre cerveau doute systématiquement de ce qu’il voit ? Comment maintenir notre besoin de justice et de vérité quand les preuves elles-mêmes deviennent suspectes ?

La littératie deepfake : apprendre à voir

Une nouvelle culture de l’image émergera forcément. Ainsi la « littératie deepfake », la capacité à comprendre, repérer et interpréter les images générées ou manipulées, deviendra une compétence civique essentielle, au même titre que savoir lire ou compter. D’ailleurs, de nouveaux métiers accompagnent déjà ces nouveaux a priori de l’image.

C’est le cas des vérificateurs multimodaux, capables de croiser texte, image et son. Citons aussi les analystes de biais cognitifs, formés à décrypter nos réflexes de croyance. Enfin, une autre profession garantit déjà la traçabilité des contenus : les architectes de confiance numérique.

Stratégies de survie dans le monde des deepfakes

Face à cette révolution technologique, les citoyens, les entreprises et les décideurs doivent développer des mécanismes d’adaptation. Et cela, dans le respect des besoins psychologiques fondamentaux tout en protégeant.

Citoyens : cultiver la vigilance et la confiance

Pour vous, citoyen, l’équilibre entre méfiance et confiance devient crucial. Reconnaître que nous voulons croire constitue le premier pas. Cette conscience de soi permet de questionner nos réactions émotionnelles face aux vidéos.

Avant de partager une image ou de réagir à une vidéo, vérifiez les Content Credentials lorsqu’ils sont disponibles. Ces « étiquettes d’authenticité » indiquent qui a produit le contenu, quand, et avec quel outil. Sur certaines plateformes comme Adobe Firefly, la BBC ou Nikon, une icône d’information (ⓘ) permet déjà de consulter ces données. Par exemple, une photo de manifestation publiée par la BBC peut comporter la mention « Taken by BBC reporter, verified via C2PA, no edits detected.» Cela ne garantit pas tout, mais c’est le nouveau réflexe de transparence numérique. Mais la vigilance ne doit pas céder à la paranoïa.

Face à l’infobésité et aux deepfakes, l’enjeu est d’apprendre à douter sans s’épuiser : identifier quelques sources fiables (médias reconnus, journalistes spécialisés, institutions publiques) et s’y tenir. Notre psychologie a besoin de ces ancrages. Nous éviterons ainsi le double écueil du cynisme (« tout est faux, donc je ne crois plus rien ») et de la peur (« tout peut être vrai, donc je ne crois plus personne »).

Cultivez un doute constructif qui questionne sans juger. Notre besoin naturel de croire n’est pas incompatible avec un esprit critique éclairé.

Prenons un exemple. Un proche partage une vidéo bouleversante sur un conflit. Plutôt que de réagir par un jugement accusateur (« Tu relayes de fausses nouvelles ! »), privilégiez une approche bienveillante. Interrogez-le sur la provenance de la vidéo. Cette démarche préserve le lien de confiance tout en encourageant la réflexion critique.

Si un appel vous bouleverse émotionnellement, c’est un signal d’alarme. Prenez le temps de respirer avant d’agir.

Un message ou un appel dit que votre compte bancaire est bloqué et vous demande un code ? Au lieu de répondre, raccrochez d’abord. Puis rappelez sur un numéro officiel ou connu pour vérifier l’authenticité.

Entreprises : équilibrer sécurité et humanité

Pour les entreprises, l’architecture de défense doit protéger sans déshumaniser. Il ne suffit pas de déployer des outils de vérification : il faut combiner contrôles techniques et validation humaine pour préserver la confiance des équipes.

Respectez le besoin de confiance des employés : vos protocoles ne doivent pas transformer le lieu de travail en environnement paranoïaque.

Testez et pilotez les nouvelles solutions de détection de contenu manipulé :

- GetReal Security : le logiciel pour sécuriser vos réunions Teams et Webex,

- Reality Defender SDK : l’outil de détection de contenus falsifiés (images, vidéos) capable de gérer de gros volumes grâce à l’optimisation Nvidia pour une détection à grande échelle.

- Aurigin Apollo : solution spécialisée pour surveiller et vérifier les canaux audio critiques.

Intégrez les standards de provenance de contenu, comme C2PA, dans vos workflows de création et de diffusion, pour garantir l’authenticité des images, vidéos et documents.

En combinant ainsi technologie, vigilance humaine et standards de confiance, vous protégez votre entreprise en toute sérénité.

Décideur : réguler sans entraver

Les nouvelles lois de Washington et Pennsylvanie, effectives en septembre 2025, sont inspirantes.

Le 27 juillet 2025, l’État de Washington a, en effet, adopté la loi SHB 1205, qui criminalise la distribution malveillante de deepfakes, qu’ils soient à caractère sexuel, politique ou autre.

Cette législation constitue la première aux États-Unis à imposer une responsabilité pénale pour toute utilisation malveillante de deepfakes, indépendamment de leur nature spécifique.

Le 7 juillet 2025, le gouverneur de Pennsylvanie, Josh Shapiro, a signé la loi Act 35, qui classe les deepfakes comme des faux numériques. La création ou la diffusion de deepfakes avec une intention frauduleuse ou nuisible est désormais passible de sanctions pénales36.

Le principe consiste à sanctionner les actions selon leur intention et le préjudice qu’elles causent, plutôt que de punir la technologie elle-même37. Autrement dit, ce n’est pas le fait d’utiliser un deepfake qui est répréhensible, mais l’usage malveillant visant à tromper, nuire ou manipuler.

Ces lois reconnaissent également la vulnérabilité psychologique des citoyens face aux contenus manipulés, tout en préservant les espaces de confiance sociale nécessaires à la vie démocratique et professionnelle38.

Deepfake : l’horizon 2030 et nos trajectoires psychologiques

Les prochaines années dessinent plusieurs trajectoires psychologiques possibles pour nos sociétés.

Scénario optimiste : vers une sagesse numérique

Dans le scénario optimiste, nous développons une sagesse numérique qui intègre notre besoin de croire tout en maintenant un scepticisme sain.

Les natifs deepfake – la génération qui grandit avec cette technologie – apprennent à naviguer entre confiance et méfiance.

Les adolescents d’aujourd’hui interrogent spontanément la source des vidéos virales et recherchent des confirmations croisées.

Scénario pessimiste : la fracture de la confiance

Dans le scénario pessimiste, la société se divise entre ceux qui refusent de croire en quoi que ce soit et ceux qui croient tout.

Notre besoin de certitude nous pousse vers des extrêmes dysfonctionnels.

L’émergence de passeports numériques d’authenticité pourrait fragmenter Internet en zones réglementaires incompatibles.

Scénario probable : l’adaptation progressive

Le scénario le plus probable demeure l’équilibre fragile.

Nous apprenons à vivre avec l’incertitude tout en préservant des espaces de confiance.

Notre psychologie s’adapte lentement, façonnant de nouveaux mécanismes de validation sociale.

Des garde-fous émergent. Ils s’accompagnent de la provenance intégrée dès la création, la détection en temps réel dans les plateformes critiques, l’éducation aux biais cognitifs dès l’école primaire, et des cadres juridiques équilibrés entre protection et liberté.

Ce qui nous attend dans les mois qui viennent

Les innovations à surveiller dans les prochains mois sont nombreuses. Après les photos Pixel 10, attendez-vous à voir la technologie C2PA s’étendre aux vidéos grand public d’ici fin 202539.

GetReal Security prépare l’intégration Zoom pour compléter Teams et Webex. Bientôt, toute réunion importante pourra être protégée automatiquement.

Les prochains deepfakes intégreront l’IA conversationnelle pour proposer des personas synthétiques capables d’interactions prolongées indétectables.

L’émergence d’outils permettant de créer ses propres versions synthétiques pour se protéger représente une forme d’immunité par inoculation.

Attendez-vous aussi à des deepfakes audio générés en temps réel pendant les appels, rendant obsolète la vérification vocale traditionnelle.

Quand l’IA transforme aussi notre manière d’écrire

Après avoir exploré comment les deepfakes transforment notre perception visuelle du réel, il faut rappeler que l’IA agit aussi sur un autre front : celui de la communication écrite elle-même. Du SEO au GEO : écrire pour les intelligences artificielles

Les internautes ne se contentent plus de Google pour leurs recherches. Ils utilisent désormais des IA génératives comme ChatGPT, Bing AI ou Grok pour obtenir des réponses. Ce changement bouleverse la logique même du référencement.

Le SEO (Search Engine Optimization) traditionnel ne suffit plus. Il doit être complété par le GEO (Generative Engine Optimization)40.

Concrètement, cela signifie que les rédacteurs doivent désormais structurer leurs contenus différemment. Un sommaire clair, un résumé synthétique au début, une FAQ à la fin – ces éléments ne sont plus de simples commodités pour le lecteur. Ils deviennent essentiels pour que les IA génératives puissent indexer, comprendre et restituer correctement l’information.

Un double bouleversement : perception et transmission de l’information

Cette transformation révèle néanmoins un paradoxe. Certes, nous avons évoqué les deepfakes qui manipulent notre perception de la réalité. Mais l’IA modifie simultanément la façon dont nous produisons et partageons la connaissance elle-même. Elle redéfinit les codes de la communication écrite, obligeant les créateurs de contenu à repenser entièrement leur approche.

Tout comme les deepfakes exploitent nos biais cognitifs, le GEO exploite les mécanismes de compréhension des IA génératives. Dans les deux cas, nous assistons à une adaptation de la forme pour influencer la perception, que ce soit celle des humains ou celle des machines.

Cette double transformation, perceptuelle avec les deepfakes, communicationnelle avec le GEO, illustre l’ampleur du bouleversement que l’IA apporte à notre société, elle redessine simultanément notre rapport à la vérité et notre façon de transmettre l’information.

Les deepfakes : révélateurs de notre condition humaine

En fin de compte, ce que les deepfakes révèlent de nous, c’est notre condition humaine. C’est l’équilibre fragile entre la raison, l’émotion et le besoin de croire qui conditionne notre perception du vrai. Ils soulignent également notre dépendance fondamentale à la confiance comme ciment social.

En définitive, cette technologie d’intelligence artificielle, à l’instar d’un miroir, reflète avec acuité nos vulnérabilités cognitives et nos besoins psychologiques les plus profonds.

Aussi, la solution aux deepfakes doit protéger sans nier notre humanité, en respectant notre besoin de croire, de faire confiance et d’appartenir. En septembre 2025, nous nous trouvons à un moment charnière.

La technologie avance à un rythme fulgurant. Notre psychologie, cependant, tente encore de trouver ses repères face à ces nouvelles réalités. C’est dans cette tension entre innovation technologique et besoins psychologiques ancestraux que se joue notre avenir.

Les deepfakes, exploitent notre instinct de croire ce que nous voyons. Ils nous rappellent tout de même que la confiance constitue un des socles de notre société.

Sans confiance, sans foi en quelque chose, nos communautés se désagrègent et la coopération devient impossible.

Notre défi consiste alors à rester ouverts à la confiance tout en développant une vigilance éclairée. Cette double capacité devient notre ressource la plus précieuse face à l’incertitude numérique.

Les deepfakes nous obligent ainsi à repenser notre relation à la vérité comme une opportunité de renforcer nos compétences critiques collectives.

Aujourd’hui, les technologies façonnent des illusions parfaites. Notre mission consiste alors à rester ouverts à la confiance tout en développant une vigilance éclairée. Cette double capacité représente notre ressource la plus précieuse.

Les deepfakes montrent que la vérité n’est plus simplement « ce que l’on voit ». Elle constitue un processus actif : vérifier, comparer, et s’appuyer sur des institutions et un consensus pour distinguer le vrai du faux.

Dans cette course entre l’intelligence artificielle et l’intelligence collective, c’est notre humanité même qui constitue notre meilleur atout. Derrière chaque technologie, il y a des choix humains. C’est à nous, collectivement, de décider quel avenir nous voulons construire.

L’IA transforme à la fois notre perception et notre manière de communiquer. Nous l’avons évoqué, les deepfakes modifient ce que nous voyons. A l’inverse, le GEO nous oblige à restructurer ce que nous écrivons. Cela nous aide finalement à mieux appréhender l’ampleur de la révolution en cours. C’est en maintenant cette double vigilance que nous pourrons naviguer dans ce nouveau monde avec sagesse.

FAQ – Foire aux questions pour comprendre les deepfakes

Qu’est-ce qu’un deepfake exactement ?

Un deepfake est un contenu synthétique (vidéo, audio ou image) généré par des algorithmes d’apprentissage automatique qui imite de manière ultraréaliste l’apparence ou la voix d’une personne réelle.

Comment reconnaître un deepfake ?

Les signes incluent des anomalies visuelles (clignements irréguliers, mouvements de lèvres désynchronisés), des incohérences dans l’éclairage, et des artefacts numériques. Cependant, les deepfakes deviennent de plus en plus difficiles à détecter à l’œil nu.

Pourquoi sommes-nous si vulnérables aux deepfakes ?

Notre cerveau privilégie naturellement l’information visuelle. Par ailleurs, nous avons un besoin psychologique de croire ce que nous voyons, surtout quand cela confirme nos attentes ou nos désirs.

Quelles technologies existent pour détecter les deepfakes ?

Les principales technologies incluent GenConViT (95% de précision en laboratoire), Intel FakeCatcher (détection biologique par pouls), Reality Defender (analyse multimodale), et C2PA (authentification préventive).

Comment me protéger des arnaques par deepfake audio ?

Soyez vigilant face aux demandes urgentes par téléphone, surtout financières. Rappelez toujours sur un numéro vérifié avant d’agir. Si un appel vous bouleverse émotionnellement, c’est un signal d’alarme.

Les deepfakes sont-ils tous malveillants ?

Non, les deepfakes ont aussi des usages légitimes : effets spéciaux au cinéma, doublage multilingue, restauration de vidéos historiques. Le problème réside dans l’usage malveillant de cette technologie.

Quel est l’impact des deepfakes sur la démocratie ?

Les deepfakes peuvent influencer les élections en créant de faux scandales politiques, fragmenter la société en tribus épistémiques, et éroder la confiance dans les institutions démocratiques.

Que faire si je découvre un deepfake ?

Signalez-le sur la plateforme concernée, informez votre entourage sans partager le contenu, et consultez des sites de vérification des faits (fact-checking) pour confirmer.

Les lois protègent-elles contre les deepfakes ?

Oui, de nouvelles lois émergent. Les États de Washington et Pennsylvanie ont adopté en septembre 2025 des législations criminalisant les usages malveillants sans brider l’innovation légitime.

Qu’est-ce que le GEO et quel est son lien avec les deepfakes ?

Le GEO (Generative Engine Optimization) est l’optimisation des contenus pour les IA génératives. Tout comme les deepfakes transforment notre perception, le GEO transforme notre manière de structurer l’information. Les deux illustrent l’impact de l’IA sur notre société.

Quel avenir pour les deepfakes ?

Trois scénarios possibles : une sagesse numérique équilibrée (optimiste), une division sociale extrême (pessimiste), ou plus probablement un équilibre fragile où nous apprenons à vivre avec l’incertitude tout en préservant des espaces de confiance.

Références

-

-

-

-

- « AI-Based Phishing Attack Using Deepfake Audio in 2025 », mitigata.com, 18 juin 2024. ↩︎

- « ABA Foundation and FBI Release New Infographic to Help Americans Spot and Avoid Deepfake Scams », aba.com, 3 septembre 2025. ↩︎

- « Starling Bank launches ‘Safe Phrases’ campaign », starlingbank.com, 18 septembre 2024. ↩︎

- Ibid. ↩︎

- John Joseph Twomey, Conor Linehan, Gillian Murphy, « Deepfakes in warfare: new concerns emerge from their use around the Russian invasion of Ukraine », theconversation.com, 26 octobre 2023. ↩︎

- Philip Marcelo, « Fake image of Pentagon explosion briefly sends jitters through stock market », apnews.com, 23 mai 2023. ↩︎

- William Audureau, « La fausse image d’une explosion au Pentagone fait brièvement douter les marchés », lemonde.fr, 24 mai 2023. ↩︎

- Ibid. ↩︎

- Heather Chen, Kathleen Magramo, « Finance worker pays out $25 million after video call with deepfake ‘chief financial officer’ », cnn.com, 4 février 2024. ↩︎

- Dan Milmo, « UK engineering firm Arup falls victim to £20m deepfake scam », theguardian.com, 17 mai 2024. Note : Le rapport de police a été déposé le 29 janvier 2024 selon « Report 3624 – AI Incident Database », incidentdatabase.ai, 2024. ↩︎

- Xia Lu, Qianshan Wang, Xiaowen Li, Guolan Wang, Yifei Chen, Xueqi Li, Haifang Li, « Connectivity reveals homology between the visual systems », Frontiers in Neuroscience, Vol. 17, 4 juillet 2023. Note : Environ 50 % du cortex cérébral est consacré au traitement visuel selon les études neuroscientifiques récentes. ↩︎

- Vaccari, C., & Chadwick, A., « Deepfakes and disinformation: exploring the impact of synthetic political video on deception, uncertainty, and trust in news », sagepub.com, 19 février 2020. ↩︎

- Köbis, N. C., Doležalová, B., & Soraperra, I., « Fooled twice: People cannot detect deepfakes but think they can », sciencedirect.com, Volume 24, Issue 11, 19 novembre 2021. ↩︎

- Chesney, R., & Citron, D. K., « Deep fakes: A looming challenge for privacy, democracy, and national security », bu.edu, California Law Review, University of California Berkeley School of Law, 2019. ↩︎

- Nuria Alina Chandra, Ryan Murtfeldt, Lin Qiu, Arnab Karmakar, Hannah Lee, Emmanuel Tanumihardja, Kevin Farhat, Ben Caffee, Sejin Paik, Changyeon Lee, Jongwook Choi, Aerin Kim, Oren Etzioni, « Deepfake-Eval-2024: A Multi-Modal In-the-Wild Benchmark of Deepfakes Circulated in 2024 », arxiv.org, Computer Vision and Pattern Recognition, 4 mars 2025. ↩︎

- « GenConViT: Deepfake Video Detection Using Generative Convolutional Vision Transformer », github.com, TrueMedia, 2023. Précision moyenne de 95,8 % et valeur AUC de 99,3 %. ↩︎

- Olivia Castaneda, Kofi So-Tang, Kiran Gurung, « Revisiting Simple Baselines for In-The-Wild Deepfake Detection », researchgate.net, 4 septembre 2025. ↩︎

- Nuria Alina Chandra et al., « Deepfake-Eval-2024: A Multi-Modal In-the-Wild Benchmark of Deepfakes Circulated in 2024 », 4 mars 2025. « Chute moyenne de l’AUC de 50 % pour la vidéo, 48 % pour l’audio et 45 % pour les modèles d’image. » ↩︎

- La photopléthysmographie consiste à mesurer les variations de l’absorption de lumière par les vaisseaux sanguins via une caméra. ↩︎

- « Intel Introduces Real-Time Deepfake Detector », newsroom.intel.com, 14 novembre 2022. ↩︎

- « Reality Defender SDK enables developers to leverage Nvidia infrastructure », biometricupdate.com, 18 août 2025. ↩︎

- « How Pixel an#ref23d Android are bringing a new level of trust to your images », security.googleblog.com, septembre 2025. ↩︎

- « Aurigin’s real-time audio deepfake detection defends against phone, video call fraud », biometricupdate.com, 3 septembre 2025. ↩︎

- « Aurigin », aurigin.ai, 2025. ↩︎

- Laura Llach, « Meet the Spanish AI model earning up to €10,000 a month », euronews.com, 22/11/2023. ↩︎

- Shannon Bond, « How AI deepfakes polluted elections in 2024 », npr.org, December 21, 2024. ↩︎

- Soubhik Barari, Christopher Lucas, Kevin Munger, «Political deepfakes are as credible as other fake media and (sometimes) real media », journals.uchicago.edu, PDF, The Journal of Politics, 87(2). University of Chicago Press , 2025. ↩︎

- Sara Savat , « Political deepfake videos no more deceptive than other fake news », washu.edu, research finds, Washington University in St. Louis, 2024., ↩︎

- Soubhik Barari, Christopher Lucas, Kevin Munger « Political Deepfakes are as Credible as Other Fake Media and (Sometimes) Real Media », christopherlucas.org, page 21, 99 pages, The Journal of Politics 87, no. 2, 2025. ↩︎

- Shannon Bond, « How AI deepfakes polluted elections in 2024 », npr.org, December 21, 2024. ↩︎

- « Social Media, Disinformation, and AI: Transforming the Landscape of the 2024 U.S. Presidential Political Campaigns », saisreview.sais.jhu.edu, January 14, 2025. ↩︎

- Cristian Vaccari, Andrew Chadwick, « Deepfakes and Disinformation: Exploring the Impact of Synthetic Political Video on Deception, Uncertainty, and Trust in News », researchgate.net, February 2020 ↩︎

- Alexander Diel, Tania Lalgi, Isabel Carolin Schröter,, Karl F. MacDorman, Martin Teufel , Alexander Bäuerle, « Human performance in detecting deepfakes: A systematic review and meta-analysis of 56 papers », sciencedirect.com, Computers in Human Behavior Reports, Volume 16, December 2024.↩︎

- Chesney, R., & Citron, D. K., « Deep fakes: A looming challenge for privacy, democracy, and national security », bu.edu, California Law Review, University of California Berkeley School of Law, 2019. ↩︎

- Brent J. Gurney, « The Other Side Says Your Evidence Is A Deepfake. Now What? », wilmerhale.com, December 21, 2022.↩︎

- Jake Goldstein-Street, « Washington AG joins push to stop spread of deepfake pornography online », washingtonstatestandard.com, September 2, 2025. ↩︎

- « Governor Shapiro Signs New Digital Forgery Law, Protecting Pennsylvanians from AI Scams and Financial Exploitation », pa.gov, July 07, 2025. ↩︎

- « Forged Faces, Real Liability: Deepfake Laws Take Effect in Washington State and Pennsylvania », crowell.com, 08.19.25 ↩︎

- Eric Lynch, « How Pixel and Android are bringing a new level of trust to your images with C2PA Content Credentials », security.googleblog.com, September 10, 2025.↩︎

- « GetReal Security Advances Continuous Identity Protection to Combat Deepfakes », getrealsecurity.com, 9/10/2025. ↩︎

-

-

-